匯付天下技術丨如何支撐海量交易的風控實時決策與靈活擴展

導語

在第三方支付領域,風控系統是保障客戶資金安全與交易合規的核心基石。面對日益增長的海量交易數據以及不斷變化的業務需求,如何選取一款具備高性能與高擴展性的數據庫,成為構建穩健風控體系的關鍵課題。本文將從技術實踐視角出發,深入解析匯付如何將MongoDB 應用在風控系統關鍵場景中,并剖析其背后的核心實現邏輯。

匯付風控系統核心挑戰

1.1 動態數據模型的需求與挑戰

風控與欺詐如同貓鼠游戲,風控規則和模型必須快速迭代,才能應對快速演變的業務需求和欺詐手段。以商戶風險評估為例,早期模型可能僅包含基礎經營數據,如月交易額、行業類別等簡單指標。但隨著業務深入,我們逐步構建了一套多維度的動態評估體系:

● 時間維度:除了基礎的"在網時長分層"(0-3月、3-6月等區間劃分),新增了"節假日交易波動率"(衡量大促期間的異常交易)、"服務時段集中度"(識別非正常營業時間的可疑交易)

● 主體特征維度:在"法人年齡梯度"(20-30歲、30-40歲等分段)基礎上,擴展了"關聯企業數量"(通過工商數據識別空殼公司)、"股東變更頻率"(捕捉惡意轉讓行為)

● 資金維度:引入"入賬出賬平衡率"(監測資金快進快出)、"異常金額占比"(統計整數交易、特定數字交易等特征)

更復雜的案例出現在設備指紋領域。為應對日益專業的欺詐手段,我們不僅需要采集設備基礎信息,還需記錄"環境特征"、"瀏覽器語言"、"行為分析"、"安全評估"等多維信息。這些指標往往需要以嵌套文檔形式存儲。這種半結構化數據在關系型數據庫中需要拆分為多張表,通過外鍵關聯,不僅增加了查詢復雜度,在字段變更時還需要執行耗時的ALTER TABLE操作,嚴重制約了風控策略的敏捷迭代。

1.2 高并發場景下的實時決策壓力

支付行業特有的流量波動對風控系統提出了雙重考驗:

瞬時并發沖擊

在商戶大促等場景下,系統需在極短時間內處理突增的交易洪流。這要求風控引擎具備:

● 毫秒級規則執行能力(典型決策窗口<50ms)

● 數百條風控規則的并行校驗能力

● 千級QPS的穩定吞吐量

多維規則校驗體系

每筆交易需通過立體化檢測:

● 基礎核驗層:黑名單實時比對(三要素校驗)

● 行為分析層:多時間窗口行為統計,交易金額/節奏異常檢測

● 時空關聯層:設備-位置-時間三維驗證

同時,支付高峰期單日產生億級交易記錄,歷史數據累積達PB級。傳統方案采用分庫分表,但擴容需停機遷移,這對支付業務來說是不可接受的。

實時聚合計算難題

與流量沖擊并存的,是日益復雜的實時聚合統計需求帶來的計算難題,例如:“商戶當日累計交易金額超過一定金額觸發人工審核”、“用戶近1小時快捷支付交易次數超限需進行二次驗證”等規則都依賴于大量的計算。在大規模交易場景下,實時聚合分析主要面臨以下三大核心問題:

● 計算耗時久:業務高峰期的聚合計算耗時遠超風控決策窗口

● 熱點放大效應:頭部商戶的密集查詢引發雪崩式性能衰減

● 資源競爭:統計計算與交易處理爭奪有限數據庫資源

風控現有數據庫的不足

2.1 MySQL的剛性結構之痛

MySQL作為傳統關系型數據庫,在風控場景中會存在以下瓶頸:

1.每次新增風控維度都需要修改表結構,在ALTER TABLE執行期間會鎖表,此類變更可能直接導致服務中斷。

2.為支持多維度查詢需要創建大量索引,某個核心表曾建有十幾個索引,過度索引雖然提升了查詢效率,卻嚴重犧牲了數據寫入性能,形成了讀寫效率難以調和的矛盾。

3.分表策略難以應對數據傾斜,由于業務本身存在明顯的頭部效應,少數高頻交易商戶產生了大量數據記錄,導致按照常規規則劃分的數據分片出現了嚴重的負載不均現象。這種數據傾斜使得部分分片持續承受超額壓力,而其他分片卻利用率不足,不僅降低了整體資源使用效率,還造成了熱點分片的性能瓶頸。

2.2 Redis的局限性

雖然Redis提供了出色的緩存性能,但在風控場景也存在明顯不足:

● 缺乏對復雜文檔的原生支持,設備指紋等嵌套層級數據需要拆分為多個鍵值存儲。

● 內存容量限制難以承載大量交易數據,僅存儲近期活躍交易數據就接近硬件承載上限。

● 聚合計算能力有限,無法直接支持多維度統計分析。

2.3 HBase的實時性短板

HBase在大數據存儲方面表現優異,但在實時風控中逐漸暴露出以下問題:

● 復雜查詢需要配合Phoenix等SQL層,引入額外延遲。

● 隨著數據規模持續擴張,范圍查詢的響應效率呈現顯著退化趨勢。

● 缺乏原生的聚合框架,統計指標需要應用層計算。

MongoDB的破局之道

3.1 動態Schema帶來的敏捷性革命

MongoDB的文檔模型高度適配了風控系統的演進需求。一個完整的設備畫像可以作為一個自包含的文檔存儲,新指標的加入就像在JSON中添加一個新字段那樣簡單。這種靈活性使得風控策略的迭代周期從原來的以周為單位,縮短到小時級別。同時,通過嵌入式文檔設計,我們將原先分散在8張MySQL表中的商戶信息整合為單一文檔,這種設計消除了復雜的JOIN操作,使典型查詢耗時從120ms降至15ms。

3.2 分片集群的彈性擴展

我們采用基于訂單ID的哈希分片策略,將數據均勻分布在3個分片上。當單個分片數據量接近警戒線時,通過添加新分片實現水平擴展,整個過程對應用完全透明。某次大促前的擴容操作僅用時半小時,期間服務零中斷。

此外,我們對歷史數據采用冷熱分層存儲架構與TTL索引相結合的方案,實現了數據全生命周期的自動化管理,在確保近期數據高效訪問的同時,顯著降低了運維復雜度。

3.3 聚合管道的性能突破

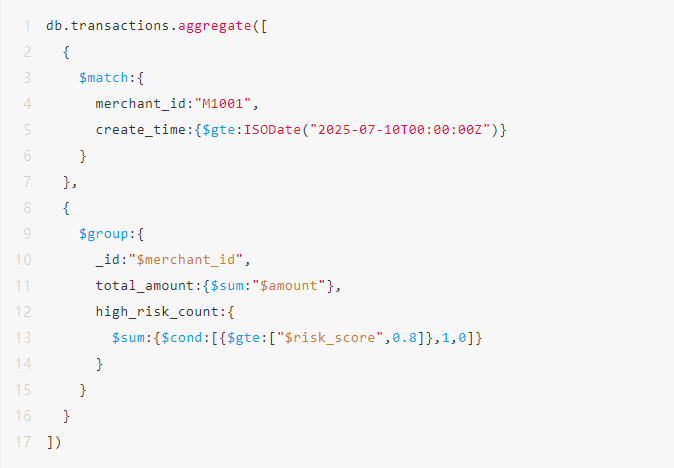

MongoDB的聚合管道查詢機制顯著提升了我們的風控時效性。以下是一個計算商戶當日交易指標的高效查詢示例:

通過利用分片集群的并行計算能力,在萬級交易記錄的分片集群上,該聚合查詢平均耗時僅28ms。

基于MongoDB的匯付風控結局方案實踐

4.1核心鏈路與準實時分析任務流量隔離

為保障核心交易鏈路毫秒級響應的穩定性,并滿足準實時分析需求,我們基于MongoDB實現了精細化的流量隔離:

我們使用主從節點(Primary/Secondary)專門處理實時交易寫入和核心風控規則評估,確保:

● 支付交易的低延遲處理

● 強一致性數據寫入

● 關鍵風控規則的毫秒級響應

使用只讀節點(Readonly Node)承載準實時分析任務,包括:

● 事后規則執行

● 商戶行為分析報告生成

● 監管合規審計查詢

并通過精細的路由策略設置確保:

● 實時交易強制路由至主庫

● 事后規則及分析類查詢自動分發到只讀節點

● 商戶基礎信息查詢與回填定向至專用副本集實例

通過以上方案實現了:

● 資源爭用消除:長耗時查詢不再阻塞交易線程

● 彈性擴展能力:可按需添加只讀節點應對分析負載增長

● 成本優化:利用標準配置節點承載非實時任務

● 穩定性提升:核心業務與數據分析故障域隔離

4.2多級緩存機制

風控規則常需實時計算用戶/商戶當日累計交易金額和筆數。對高頻商戶進行全表掃描匯總,耗時會指數級上升,成為性能瓶頸。為此,我們設計了多級緩存機制:

我們使用動態時間窗口緩存機制,解決了熱點商戶查詢問題。具體機制如下:

1.當查詢商戶當日累計金額時,系統首先檢查緩存數據,如果緩存包含0點到T1的數據,則只需額外統計T1至今的數據即可;

2.若未命中則執行全量查詢,當檢測到查詢頻率超過閾值時,更新緩存結果,并自動擴展緩存時間至當前時間。

同時,我們采用定時校驗+內存磁盤雙寫機制確保緩存數據一致性和可靠性:

1.后臺任務每10分鐘比對緩存與數據庫的差異并進行結果修正(部分交易在完成后,其最終狀態通知到風控可能存在數分鐘的延遲,定時校驗可修正因這種延遲導致的緩存與數據庫之間的狀態不一致);

2.定期將緩存結果回寫NAS共享存儲,應用重啟時優先加載持久化結果。

通過上述方案,在保障實時統計精度的前提下,顯著提升了匯付風控系統的吞吐能力,將緩存誤差控制在千分之一量級,同時減少了30%以上重復查詢量。

落地成果

經過MongoDB架構改造后,匯付風控系統實現了全方位的性能突破:

● 規則響應效率顯著提升:系統平均響應時間縮短至原先的1/4,從原先的百毫秒級優化至50ms響應,滿足支付業務對實時風控的嚴苛要求。

● 策略迭代周期大幅縮短:風控策略上線周期從原先以周為單位的流程,壓縮至小時級別即可完成,極大增強了業務敏捷性。

● 存儲成本有效優化:通過數據分層存儲方案,整體存儲成本降低30%,在保證查詢性能的同時實現了顯著的成本節約。

● 系統容量跨越式增長:峰值吞吐量達到改造前的6倍,為業務爆發式增長提供了堅實保障。

結語

MongoDB在匯付風控系統的成功實踐證明,現代NoSQL數據庫已不再是簡單的數據存儲工具,而是能夠驅動業務創新的核心引擎。通過靈活的數據模型、強大的水平擴展能力和實時的計算框架,我們構建了高彈性、高可用的風控體系。未來,隨著AI技術與數據庫的深度融合,這一平臺將持續進化,為支付安全構筑更智能的防線。在數字化支付的新紀元,科學的技術選型為業務發展提供持續動能,選擇正確的技術底座,就是選擇業務的未來。